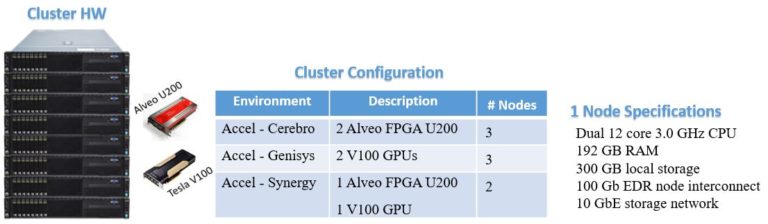

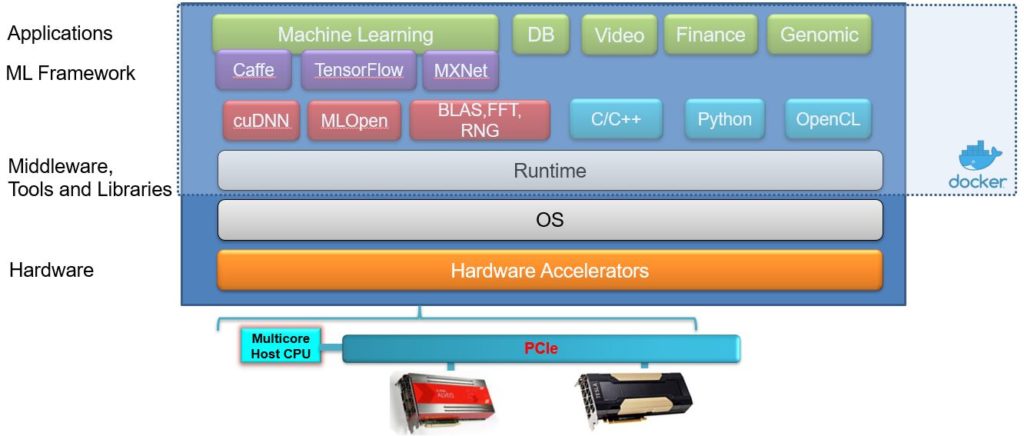

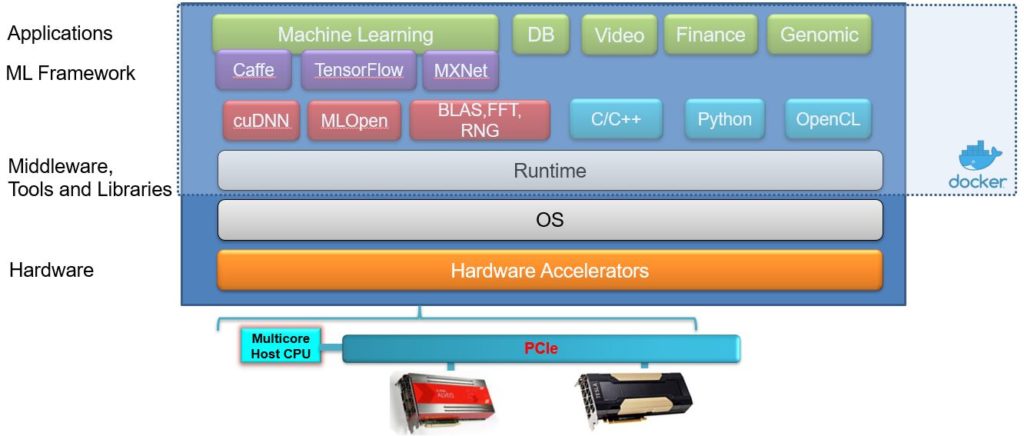

Les technologies d’accélération les plus récentes, y compris les FPGA Alveo et les GPU Tesla V100, étroitement couplées aux processeurs serveur, constituent l’épine dorsale de ce groupe. La pile logicielle est constituée d’un écosystème complet de cadres d’apprentissage machine, de bibliothèques et d’accélérateurs de calcul hétérogènes orientés sur le temps d’exécution.

Groupe FPGA/GPU - Pile logicielle

Le groupe FPGA/GPU prend en charge trois des cadres d’apprentissage en profondeur les plus couramment utilisés, à savoir TensorFlow, Caffe et MXNet. Ces cadres fournissent une couche d’abstraction de haut niveau pour la spécification de l’architecture d’apprentissage en profondeur, la formation de modèles, le réglage, les tests et la validation. La pile logicielle comprend également plusieurs bibliothèques spécifiques à chaque fournisseur d’apprentissage de machines qui fournissent des fonctions informatiques dédiées adaptées à une architecture matérielle spécifique, fournissant le meilleur rendement/puissance possible.

Applications

- Applications des IP et des logiciels ciblant le ML sur des systèmes informatiques hétérogènes (par exemple CNN, pour la détection d’objets, la reconnaissance vocale)

- Pile logicielle comprenant : Modèles de programmation parallèles, compilateurs, intergiciels, exécution, moteurs et systèmes d’exploitation

- Études de cas : ML, analyse de données massives, calcul intensif de données, cybersécurité

- Prototypage des ASIC : par exemple, CMOS et autres semiconducteurs, pour la mise en oeuvre d’accélérateurs de réseau neuronal personnalisés

Ressources

Avantages

- Accès à distance sécurisé

- Cadres d’apprentissage automatique : Tensorflow, caffe et MXNet

- Appui à la formation et à l’inférence en matière d’apprentissage en profondeur

- Personnalisation : Sélectionnez la bonne combinaison d’accélérateurs pour votre application

- Conception de référence à l’aide d’une pile logicielle pour OpenCL, MPI, le groupe informatique hétérogène

- Évolutivité : Créer un graphique de réseau neuronal d’un noeud et le mettre à l’échelle en utilisant plus de noeuds

- Configuration automatisée et rapide